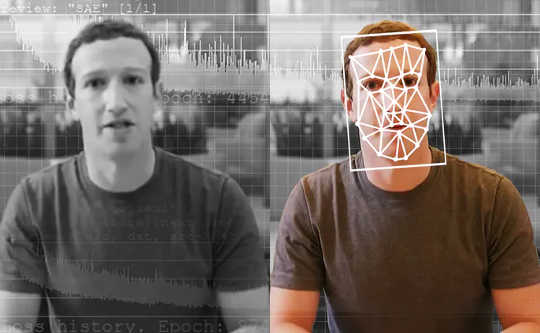

KI-gesteuerte Detektoren sind die besten Werkzeuge zum Erkennen von KI-generierten gefälschten Videos. Die Washington Post über Getty Images

Ein investigativer Journalist erhält ein Video von einem anonymen Whistleblower. Es zeigt einen Präsidentschaftskandidaten, der illegale Aktivitäten zugibt. Aber ist dieses Video echt? Wenn ja, wäre dies eine große Neuigkeit - die Kugel Ihres Lebens - und könnte die bevorstehenden Wahlen komplett umkehren. Die Journalistin führt das Video jedoch über ein spezielles Tool aus, das ihr sagt, dass das Video nicht so ist, wie es scheint. In der Tat ist es ein “Deepfake, ”Ein Video, das mit künstlicher Intelligenz erstellt wurde tiefe Lernen.

Journalisten auf der ganzen Welt könnten bald ein solches Tool verwenden. In ein paar Jahren könnte ein solches Tool sogar von jedem verwendet werden, um gefälschte Inhalte in seinen Social-Media-Feeds auszurotten.

As Forscher die Deepfake-Erkennung untersucht haben Wenn wir ein Tool für Journalisten entwickeln, sehen wir eine Zukunft für diese Tools. Sie werden jedoch nicht alle unsere Probleme lösen, und sie werden nur ein Teil des Arsenals im breiteren Kampf gegen Desinformation sein.

Das Problem mit Deepfakes

Die meisten Menschen wissen, dass Sie nicht alles glauben können, was Sie sehen. In den letzten Jahrzehnten haben sich versierte Nachrichtenkonsumenten daran gewöhnt, Bilder zu sehen, die mit Fotobearbeitungssoftware manipuliert wurden. Videos sind jedoch eine andere Geschichte. Hollywood-Regisseure können Millionen von Dollar für Spezialeffekte ausgeben, um eine realistische Szene zu erstellen. Aber mit Deepfakes könnten Amateure mit ein paar tausend Dollar Computerausrüstung und ein paar Wochen etwas fast so lebensecht machen.

Deepfakes ermöglichen es, Menschen in Filmszenen zu versetzen, in denen sie nie waren - Denken Sie, Tom Cruise spielt Iron Man - was für unterhaltsame Videos sorgt. Leider macht es auch möglich zu erstellen Pornografie ohne die Zustimmung der abgebildeten Personen. Bisher sind diese Menschen, fast alle Frauen, die größten Opfer, wenn Deepfake-Technologie missbraucht wird.

Deepfakes können auch verwendet werden, um Videos von politischen Führern zu erstellen, die Dinge sagen, die sie nie gesagt haben. Die belgische Sozialistische Partei veröffentlichte ein nicht schlechtes, aber immer noch falsches Video von geringer Qualität Präsident Trump beleidigt Belgien, die genug Reaktion bekam, um die potenziellen Risiken von Deepfakes höherer Qualität aufzuzeigen.

{vembed Y=poSd2CyDpyA}

Hany Farid von der University of California in Berkeley erklärt, wie Deepfakes gemacht werden.

Vielleicht am gruseligsten von allenkönnen sie zum Erstellen verwendet werden Zweifel am Inhalt von echten Videosdurch den Hinweis, dass es sich um Deepfakes handeln könnte.

Angesichts dieser Risiken wäre es äußerst wertvoll, Deepfakes erkennen und eindeutig kennzeichnen zu können. Dies würde sicherstellen, dass gefälschte Videos die Öffentlichkeit nicht täuschen und dass echte Videos als authentisch empfangen werden können.

Fälschungen entdecken

Die Deepfake-Erkennung als Forschungsgebiet wurde etwas früher begonnen vor drei Jahren. Frühe Arbeiten konzentrierten sich auf das Erkennen sichtbarer Probleme in den Videos, wie z Deepfakes, die nicht blinzelten. Mit der Zeit jedoch die Fälschungen sind besser geworden bei der Nachahmung realer Videos und für Personen und Erkennungswerkzeuge schwerer zu erkennen.

Es gibt zwei Hauptkategorien der Deepfake-Detektionsforschung. Der erste beinhaltet das Verhalten von Menschen betrachten in den Videos. Angenommen, Sie haben eine Menge Videos von jemandem, der berühmt ist, wie Präsident Obama. Künstliche Intelligenz kann dieses Video verwenden, um seine Muster zu lernen, von seinen Handgesten bis zu seinen Sprachpausen. Es kann dann beobachte eine tiefe Fälschung von ihm und beachten Sie, wo es nicht mit diesen Mustern übereinstimmt. Dieser Ansatz hat den Vorteil, dass er möglicherweise auch dann funktioniert, wenn die Videoqualität selbst im Wesentlichen perfekt ist.

{vembed Y=gsv1OsCEad0}

Aaron Lawson von SRI International beschreibt einen Ansatz zur Erkennung von Deepfakes.

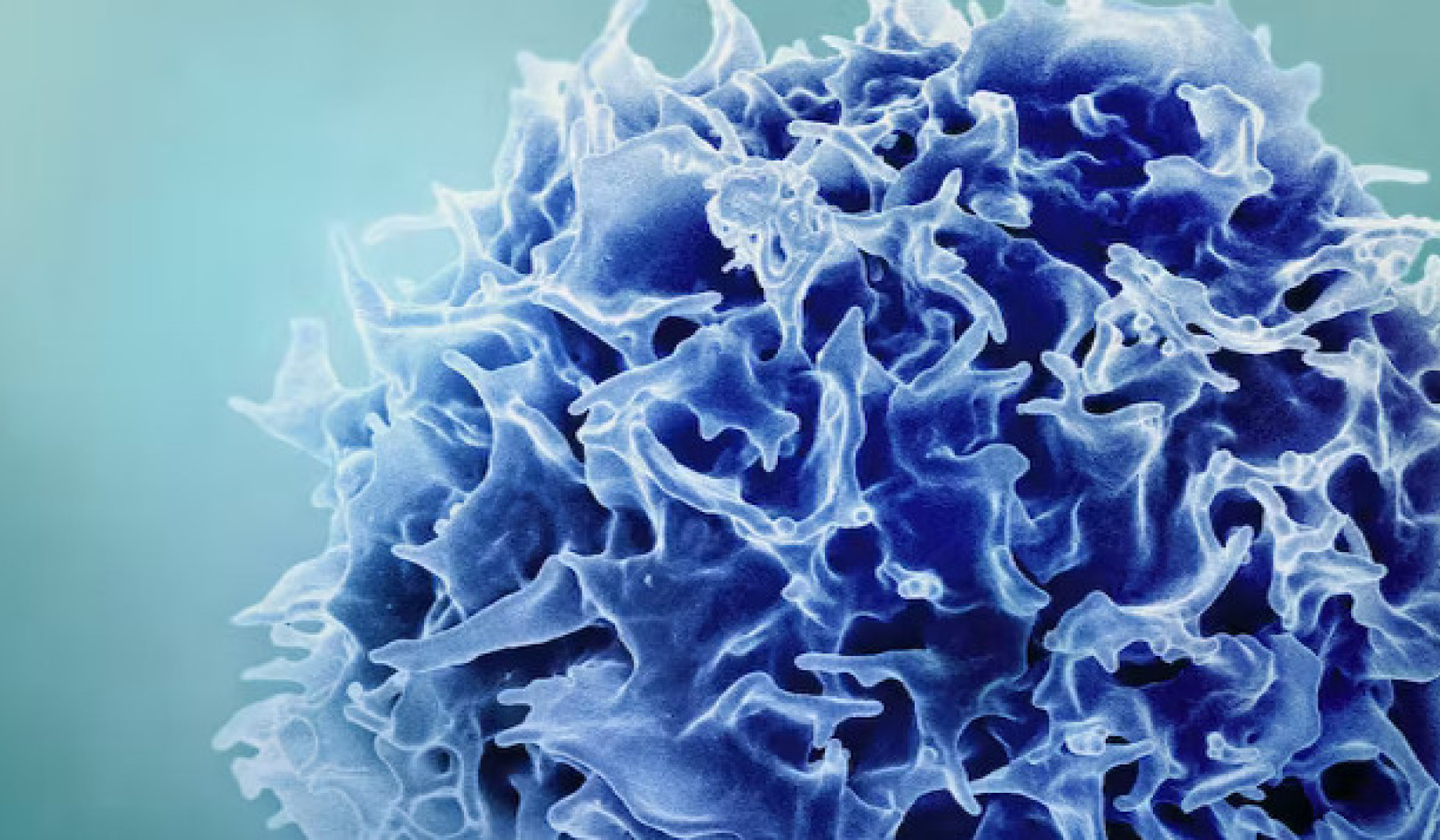

Andere Forscher, einschließlich unseres Teamswurden konzentriert Unterschiede zur Verbesserung der Gesundheitsgerechtigkeit Alle Deepfakes haben im Vergleich zu echten Videos. Deepfake-Videos werden häufig durch Zusammenführen einzeln generierter Frames zu Videos erstellt. Unter Berücksichtigung dessen extrahieren die Methoden unseres Teams die wesentlichen Daten aus den Gesichtern in einzelnen Bildern eines Videos und verfolgen sie dann durch Sätze gleichzeitiger Bilder. Auf diese Weise können wir Inkonsistenzen im Informationsfluss von einem Frame zum anderen erkennen. Einen ähnlichen Ansatz verwenden wir auch für unser gefälschtes Audioerkennungssystem.

Diese subtilen Details sind für die Menschen schwer zu erkennen, zeigen aber, dass Deepfakes nicht ganz sind noch perfekt. Detektoren wie diese können für jede Person funktionieren, nicht nur für einige wenige Weltmarktführer. Am Ende kann es sein, dass beide Arten von Deepfake-Detektoren benötigt werden.

Neuere Erkennungssysteme arbeiten sehr gut mit Videos, die speziell für die Bewertung der Tools gesammelt wurden. Leider tun es auch die besten Modelle schlecht auf Videos online gefunden. Der wichtigste Schritt besteht darin, diese Tools robuster und nützlicher zu machen.

Wer sollte Deepfake-Detektoren verwenden?

Im Idealfall sollte jedem ein Deepfake-Verifizierungs-Tool zur Verfügung stehen. Diese Technologie befindet sich jedoch in einem frühen Entwicklungsstadium. Forscher müssen die Tools verbessern und vor Hackern schützen, bevor sie allgemein veröffentlicht werden.

Gleichzeitig stehen die Werkzeuge zur Herstellung von Deepfakes jedem zur Verfügung, der die Öffentlichkeit zum Narren halten möchte. Am Rande zu sitzen ist keine Option. Für unser Team bestand die richtige Balance darin, mit Journalisten zusammenzuarbeiten, da diese die erste Verteidigungslinie gegen die Verbreitung von Fehlinformationen darstellen.

Vor dem Veröffentlichen von Geschichten müssen Journalisten die Informationen überprüfen. Sie haben bereits bewährte Methoden, wie das Überprüfen mit Quellen und das Überprüfen der wichtigsten Fakten durch mehr als eine Person. Indem wir das Tool in ihre Hände geben, geben wir ihnen mehr Informationen und wir wissen, dass sie sich nicht nur auf die Technologie verlassen werden, da sie Fehler machen kann.

Können die Detektoren das Wettrüsten gewinnen?

Es ist ermutigend, Teams von zu sehen Facebook und Microsoft Investition in Technologie, um Deepfakes zu verstehen und zu erkennen. Dieses Gebiet benötigt mehr Forschung, um mit den Fortschritten in der Deepfake-Technologie Schritt zu halten.

Journalisten und die Social-Media-Plattformen müssen auch herausfinden, wie sie Menschen am besten vor Deepfakes warnen können, wenn sie entdeckt werden. Untersuchungen haben das gezeigt Leute erinnern sich an die Lüge, aber nicht die Tatsache, dass es eine Lüge war. Gilt das auch für gefälschte Videos? Nur „Deepfake“ in den Titel zu setzen, reicht möglicherweise nicht aus, um einigen Arten von Desinformation entgegenzuwirken.

Deepfakes sind hier, um zu bleiben. Der Umgang mit Desinformation und der Schutz der Öffentlichkeit werden schwieriger als je zuvor, da künstliche Intelligenz immer leistungsfähiger wird. Wir sind Teil einer wachsenden Forschungsgemeinschaft, die sich dieser Bedrohung stellt, bei der die Erkennung nur der erste Schritt ist.![]()

Über die Autoren

John Sohrawardi, Doktorand in Computer- und Informationswissenschaften, Rochester Institute of Technology und Matthew Wright, Professor für Computersicherheit, Rochester Institute of Technology

Dieser Artikel wird erneut veröffentlicht Das Gespräch unter einer Creative Commons-Lizenz. Lies das Original Artikel.