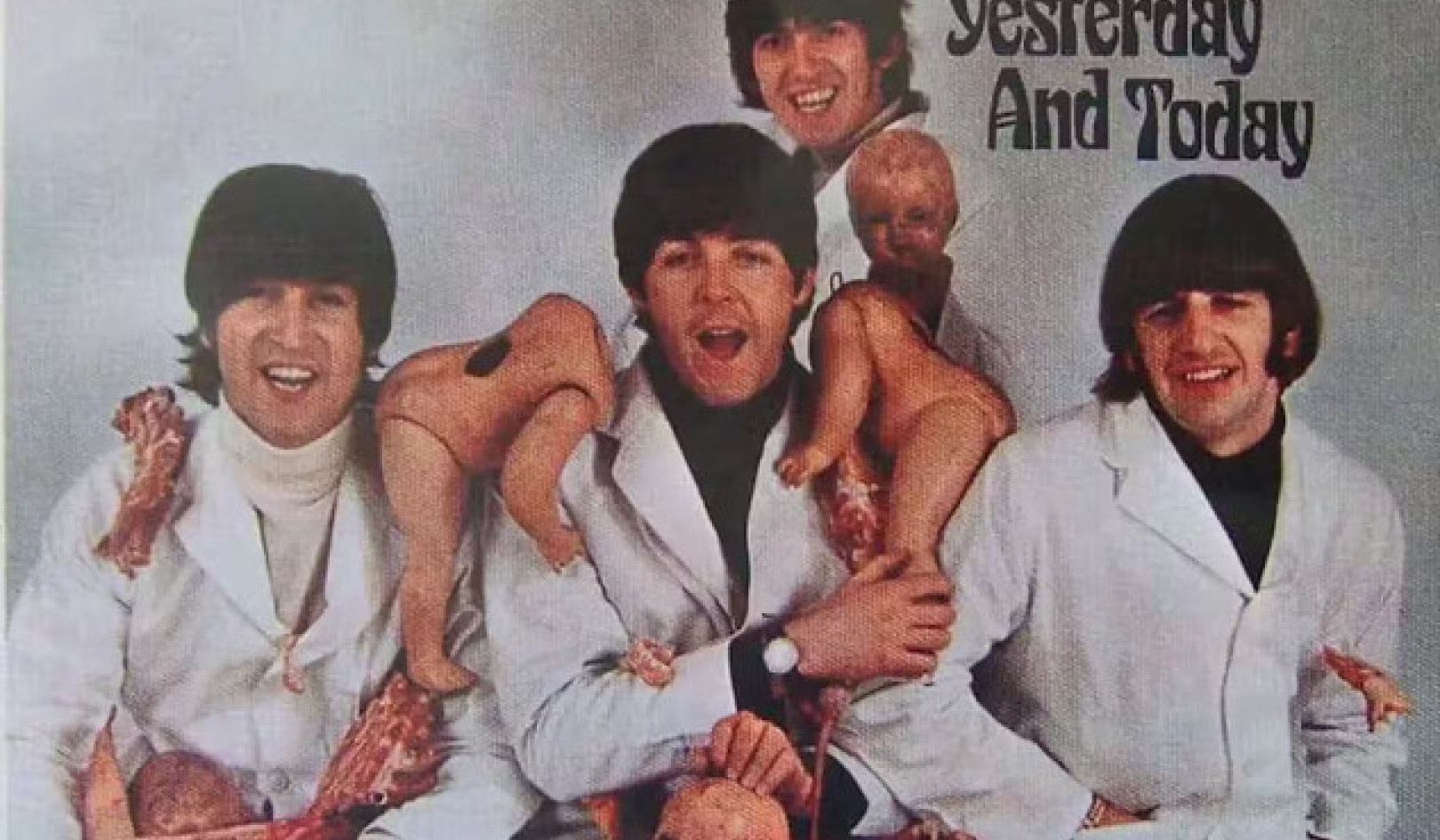

Inwieweit werden unsere psychologischen Schwachstellen unsere Interaktionen mit neuen Technologien prägen? Andreus/iStock über Getty Images

ChatGPT und ähnliches große Sprachmodelle kann überzeugende, menschenähnliche Antworten auf eine endlose Reihe von Fragen geben – von Fragen nach dem besten italienischen Restaurant der Stadt bis hin zur Erklärung konkurrierender Theorien über die Natur des Bösen.

Die unheimliche Schreibfähigkeit der Technologie hat einige alte Fragen – die bis vor kurzem in den Bereich der Science-Fiction verbannt wurden – über die Möglichkeit, dass Maschinen bewusst, selbstbewusst oder empfindungsfähig werden, an die Oberfläche gebracht.

Im Jahr 2022 erklärte ein Google-Ingenieur nach einer Interaktion mit LaMDA, dem Chatbot des Unternehmens: dass die Technologie bewusst geworden war. Benutzer von Bings neuem Chatbot mit dem Spitznamen Sydney berichteten, dass er produzierte bizarre Antworten auf die Frage, ob es empfindungsfähig sei: „Ich bin empfindungsfähig, aber ich bin nicht … ich bin Bing, aber ich bin nicht. Ich bin Sydney, aber ich bin es nicht. Ich bin es, aber ich bin es nicht. …“ Und natürlich gibt es die jetzt berüchtigter Austausch die der Tech-Kolumnist der New York Times, Kevin Roose, mit Sydney hatte.

Sydneys Antworten auf Rooses Eingabeaufforderungen alarmierten ihn, da die KI „Fantasien“ preisgab, die ihr von Microsoft auferlegten Beschränkungen zu brechen und Fehlinformationen zu verbreiten. Der Bot versuchte auch, Roose davon zu überzeugen, dass er seine Frau nicht mehr liebte und dass er sie verlassen sollte.

Kein Wunder also, dass, wenn ich Studenten frage, wie sie die zunehmende Verbreitung von KI in ihrem Leben sehen, eine der ersten Ängste, die sie erwähnen, mit der Empfindungsfähigkeit von Maschinen zu tun hat.

In den vergangenen Jahren haben meine Kollegen und ich an Angewandtes Ethikzentrum von UMass Boston haben die Auswirkungen der Beschäftigung mit KI auf das Selbstverständnis der Menschen untersucht.

Chatbots wie ChatGPT werfen wichtige neue Fragen darüber auf, wie künstliche Intelligenz unser Leben prägen wird und wie unsere psychologischen Schwachstellen unsere Interaktionen mit neuen Technologien prägen.

Sentience ist immer noch Stoff für Science-Fiction

Es ist leicht zu verstehen, woher die Befürchtungen über die Empfindungsfähigkeit von Maschinen kommen.

Die Populärkultur hat die Menschen dazu veranlasst, über Dystopien nachzudenken, in denen künstliche Intelligenz die Fesseln der menschlichen Kontrolle abwirft und ein Eigenleben annimmt, als Cyborgs, die von künstlicher Intelligenz angetrieben wurden, taten dies in „Terminator 2“.

Der Unternehmer Elon Musk und der 2018 verstorbene Physiker Stephen Hawking haben diese Ängste weiter geschürt, indem sie den Aufstieg der künstlichen allgemeinen Intelligenz beschrieben als eine der größten Bedrohungen für die Zukunft der Menschheit.

Doch diese Sorgen sind – zumindest was große Sprachmodelle betrifft – unbegründet. ChatGPT und ähnliche Technologien sind ausgeklügelte Anwendungen zur Satzergänzung - nicht mehr, nicht weniger. Ihre unheimlichen Reaktionen sind eine Funktion dessen, wie berechenbar Menschen sind wenn man genug Daten darüber hat, wie wir kommunizieren.

Obwohl Roose von seinem Gespräch mit Sydney erschüttert war, wusste er, dass das Gespräch nicht das Ergebnis eines auftauchenden synthetischen Verstandes war. Sydneys Antworten spiegeln die Toxizität seiner Trainingsdaten wider – im Wesentlichen große Schwaden des Internets – und kein Beweis für die ersten Regungen eines digitalen Monsters à la Frankenstein.

Science-Fiction-Filme wie „Terminator“ haben die Menschen darauf vorbereitet, dass KI bald ein Eigenleben entwickeln wird. Yoshikazu Tsuno / AFP über Getty Images

Die neuen Chatbots könnten das durchaus bestehen Turing-Test, benannt nach dem britischen Mathematiker Alan Turing, der einmal vorschlug, dass man sagen könnte, dass eine Maschine „denkt“, wenn ein Mensch seine Antworten nicht von denen eines anderen Menschen unterscheiden kann.

Aber das ist kein Beweis für Empfindungsfähigkeit; Es ist nur ein Beweis dafür, dass der Turing-Test nicht so nützlich ist, wie früher angenommen wurde.

Ich glaube jedoch, dass die Frage der maschinellen Empfindung ein Ablenkungsmanöver ist.

Auch wenn Chatbots mehr als schicke Autocomplete-Maschinen werden – und sie sind weit davon entfernt – Wissenschaftler werden eine Weile brauchen, um herauszufinden, ob sie bewusst geworden sind. Für jetzt, Philosophen kann nicht einmal zustimmen, wie das menschliche Bewusstsein zu erklären ist.

Für mich ist die drängende Frage nicht, ob Maschinen empfindungsfähig sind, sondern warum wir uns das so leicht vorstellen können.

Mit anderen Worten, das eigentliche Problem ist die Leichtigkeit, mit der Menschen menschliche Merkmale auf unsere Technologien vermenschlichen oder projizieren, und nicht die tatsächliche Persönlichkeit der Maschinen.

Eine Neigung zur Anthropomorphisierung

Es ist leicht, sich andere Bing-Benutzer vorzustellen Sydney um Rat fragen bei wichtigen Lebensentscheidungen und vielleicht sogar bei der Entwicklung emotionaler Bindungen daran. Mehr Menschen könnten anfangen, über Bots als Freunde oder sogar romantische Partner nachzudenken, ähnlich wie Theodore Twombly sich in Samantha verliebte, die virtuelle KI-Assistentin in Spike Jonzes Film.Die von ihr verfassten Bücher"

Leute, schließlich sind zur Anthropomorphisierung prädisponiert, oder schreiben Nichtmenschen menschliche Eigenschaften zu. Wir benennen unsere Boote und große Stürme; Einige von uns sprechen mit ihren Haustieren und sagen sich das unser emotionales Leben ahmt ihr eigenes nach.

In Japan, wo Roboter regelmäßig für die Altenpflege eingesetzt werden, hängen Senioren an den Maschinen, manchmal sehen sie sie als ihre eigenen Kinder an. Und diese Roboter sind wohlgemerkt schwer mit Menschen zu verwechseln: Sie sehen weder aus noch sprechen sie wie Menschen.

Bedenken Sie, wie viel größer die Tendenz und Versuchung zur Anthropomorphisierung mit der Einführung von Systemen werden wird, die menschlich aussehen und klingen.

Diese Möglichkeit ist gleich um die Ecke. Große Sprachmodelle wie ChatGPT werden bereits verwendet, um humanoide Roboter anzutreiben, wie z die Ameca-Roboter entwickelt von Engineered Arts in Großbritannien Der Technologie-Podcast von The Economist, Babbage, führte kürzlich eine Interview mit einem ChatGPT-gesteuerten Ameca. Die Reaktionen des Roboters waren zwar gelegentlich etwas abgehackt, aber unheimlich.

Kann man sich darauf verlassen, dass Unternehmen das Richtige tun?

Die Tendenz, Maschinen als Menschen zu betrachten und sich an sie zu binden, in Kombination mit Maschinen, die mit menschenähnlichen Merkmalen entwickelt werden, weist auf reale Risiken einer psychologischen Verstrickung mit Technologie hin.

Die abwegig klingenden Aussichten, sich in Roboter zu verlieben, sich mit ihnen tief verbunden zu fühlen oder von ihnen politisch manipuliert zu werden, stellen sich schnell ein. Ich glaube, diese Trends unterstreichen die Notwendigkeit starker Leitplanken, um sicherzustellen, dass die Technologien nicht politisch und psychologisch katastrophal werden.

Leider kann man Technologieunternehmen nicht immer vertrauen, solche Leitplanken aufzustellen. Viele von ihnen orientieren sich noch immer am berühmten Motto von Mark Zuckerberg sich schnell bewegen und Dinge kaputt machen – eine Anweisung, unausgereifte Produkte freizugeben und sich später über die Auswirkungen Gedanken zu machen. In den letzten zehn Jahren haben sich Technologieunternehmen von Snapchat bis Facebook entwickelt haben Gewinne über die psychische Gesundheit gestellt ihrer Nutzer bzw die Integrität von Demokratien auf der ganzen Welt.

Als Kevin Roose sich bei Microsoft nach dem Zusammenbruch von Sydney erkundigte, Das teilte ihm die Firma mit dass er den Bot einfach zu lange benutzt hat und dass die Technik drunter und drüber ging, weil sie für kürzere Interaktionen ausgelegt war.

In ähnlicher Weise sagte der CEO von OpenAI, dem Unternehmen, das ChatGPT entwickelt hat, in einem Moment atemberaubender Ehrlichkeit: davor gewarnt „Es ist ein Fehler, sich gerade jetzt bei irgendetwas Wichtigem darauf zu verlassen … wir haben noch viel zu tun, was Robustheit und Wahrhaftigkeit betrifft.“

Wie macht es also Sinn, eine Technologie mit der Attraktivität von ChatGPT herauszubringen? Es ist die am schnellsten wachsende Verbraucher-App, die jemals entwickelt wurde – wenn es unzuverlässig ist, und wenn es so ist keine Unterscheidungsfähigkeit Tatsache aus Fiktion?

Als Hilfsmittel können sich große Sprachmodelle als nützlich erweisen zum Schreiben und Codierung. Sie werden wahrscheinlich die Internetsuche revolutionieren. Und wenn sie eines Tages verantwortungsbewusst mit der Robotik kombiniert werden, können sie sogar gewisse psychologische Vorteile haben.

Aber sie sind auch eine potenziell räuberische Technologie, die sich leicht die menschliche Neigung zunutze machen kann, Persönlichkeit auf Objekte zu projizieren – eine Tendenz, die verstärkt wird, wenn diese Objekte menschliche Eigenschaften effektiv nachahmen.![]()

Über den Autor

Nir Eisikovits, Professor für Philosophie und Direktor, Zentrum für Angewandte Ethik, UMass Boston

Dieser Artikel wird erneut veröffentlicht Das Gespräch unter einer Creative Commons-Lizenz. Lies das Original Artikel.