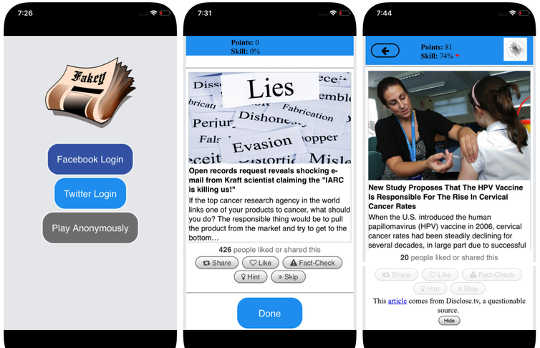

Screenshots des Fakey-Spiels. Mihai Avram und Filippo Menczer

Screenshots des Fakey-Spiels. Mihai Avram und Filippo Menczer

Social Media gehören zu den primäre Nachrichtenquellen in den USA und auf der ganzen Welt. Dennoch sind Benutzer Inhalten von fragwürdiger Genauigkeit ausgesetzt, einschließlich Verschwörungstheorien, Clickbait, Hyperpartisan Inhalt, Pseudowissenschaft und sogar fabrizierte "Fake News" -Berichte.

Es ist nicht überraschend, dass so viele Desinformationen veröffentlicht werden: Spam und Online-Betrug sind für Kriminelle lukrativund Regierung und politische Propaganda geben nach sowohl parteiische als auch finanzielle Vorteile. Aber die Tatsache, dass Inhalte mit geringer Glaubwürdigkeit verbreiten sich so schnell und einfach schlägt vor, dass die Menschen und die Algorithmen hinter Social-Media-Plattformen anfällig für Manipulationen sind.

Unsere Forschung hat drei Arten von Verzerrungen identifiziert, die das soziale Medien-Ökosystem sowohl für absichtliche als auch versehentliche Fehlinformationen anfällig machen. Deshalb unsere Observatorium für soziale Medien an der Universität von Indiana baut Werkzeuge Menschen dabei zu helfen, sich dieser Voreingenommenheit bewusst zu werden und sich vor äußeren Einflüssen zu schützen, die darauf abzielen, sie auszunutzen.

Erläuterung der am Observatorium für soziale Medien entwickelten Instrumente:

{youtube}https://youtu.be/BIv9054dBBI{/youtube}

Voreingenommenheit im Gehirn

Kognitive Verzerrungen entstehen in der Art und Weise, wie das Gehirn die Informationen verarbeitet, die jeder Mensch täglich antrifft. Das Gehirn kann nur mit einer begrenzten Menge von Informationen umgehen, und zu viele eingehende Stimuli können dies verursachen Information Overload. Das hat ernsthafte Auswirkungen auf die Qualität von Informationen in sozialen Medien. Wir haben festgestellt, dass ein starker Wettbewerb um die eingeschränkte Aufmerksamkeit der Nutzer dies bedeutet Einige Ideen werden trotz ihrer geringen Qualität viral - auch wenn Menschen es vorziehen, qualitativ hochwertige Inhalte zu teilen.

Um nicht überfordert zu werden, benutzt das Gehirn ein Anzahl der Tricks. Diese Methoden sind normalerweise effektiv, können aber auch Vorurteile werden wenn es in den falschen Kontexten angewendet wird.

Eine kognitive Abkürzung tritt auf, wenn eine Person entscheidet, ob sie eine Geschichte teilen möchte, die auf ihrem Social-Media-Feed erscheint. Menschen sind sehr betroffen von den emotionalen Konnotationen einer Überschrift, obwohl das kein guter Indikator für die Genauigkeit eines Artikels ist. Viel wichtiger ist Wer hat das Stück geschrieben?.

Um dieser Voreingenommenheit entgegenzuwirken und den Menschen zu helfen, der Quelle einer Forderung mehr Aufmerksamkeit zu schenken, bevor wir sie teilen, haben wir uns weiterentwickelt Fakey, ein mobiles Nachrichtenkompetenz - Spiel (kostenlos auf Android und iOS) Simulieren eines typischen Social-Media-News-Feeds mit einer Mischung aus Nachrichtenartikeln aus Mainstream- und Quellen mit niedriger Glaubwürdigkeit. Die Spieler erhalten mehr Punkte für den Austausch von Nachrichten aus zuverlässigen Quellen und das Markieren verdächtiger Inhalte zur Überprüfung der Fakten. Dabei lernen sie, Signale der Glaubwürdigkeit der Quelle zu erkennen, wie zum Beispiel hyperpartisierende Behauptungen und emotional aufgeladene Schlagzeilen.

Voreingenommenheit in der Gesellschaft

Eine weitere Quelle der Befangenheit kommt von der Gesellschaft. Wenn Menschen sich direkt mit Gleichaltrigen verbinden, kommen die sozialen Neigungen, die ihre Auswahl von Freunden lenken, dazu, die Informationen zu beeinflussen, die sie sehen.

Tatsächlich haben wir in unseren Untersuchungen festgestellt, dass es möglich ist Bestimmen Sie die politischen Neigungen eines Twitter-Nutzers indem man einfach die parteiischen Vorlieben ihrer Freunde betrachtet. Unsere Analyse der Struktur dieser parteiische Kommunikationsnetze Soziale Netzwerke sind besonders effizient bei der Verbreitung von Informationen - genau oder nicht - wann Sie sind eng miteinander verbunden und von anderen Teilen der Gesellschaft getrennt.

Die Tendenz, Informationen besser zu bewerten, wenn sie aus ihren eigenen sozialen Kreisen kommen, schafft "Echokammern"Die reif sind für Manipulation, entweder bewusst oder unabsichtlich. Dies erklärt, warum so viele Online-Unterhaltungen entstehen "Wir gegen sie" Konfrontationen.

Um zu untersuchen, wie die Struktur sozialer Online-Netzwerke die Benutzer anfällig für Desinformation macht, haben wir aufgebaut Hoaxieein System, das die Verbreitung von Inhalten aus Quellen mit niedriger Glaubwürdigkeit verfolgt und visualisiert und mit Inhaltsüberprüfungsinhalten konkurriert. Unsere Analyse der von Hoaxy während der 2016 US Präsidentschaftswahlen gesammelten Daten zeigt, dass Twitter Accounts, die Fehlinformationen geteilt haben, waren fast vollständig abgeschnitten von den Korrekturen, die von den Fakt-Kontrolleuren gemacht werden.

Als wir auf die fehlinformationen verbreitenden Konten drängten, fanden wir eine sehr dichte Kerngruppe von Konten, die sich fast ausschließlich retweeten - einschließlich mehrerer Bots. Die einzigen Male, in denen Faktencheck-Organisationen von den Benutzern der fehlinformierten Gruppe zitiert oder erwähnt wurden, war die Frage nach ihrer Legitimität oder nach dem Gegenteil von dem, was sie geschrieben hatten.

Vorspannung in der Maschine

Die dritte Gruppe von Verzerrungen ergibt sich direkt aus den Algorithmen, die verwendet werden, um zu bestimmen, was Menschen online sehen. Sowohl Social-Media-Plattformen als auch Suchmaschinen setzen sie ein. Diese Personalisierungstechnologien zielen darauf ab, nur den ansprechendsten und relevantesten Inhalt für jeden einzelnen Benutzer auszuwählen. Dies kann jedoch dazu führen, dass die kognitiven und sozialen Vorurteile der Nutzer verstärkt werden und sie dadurch noch manipulierbarer werden.

Zum Beispiel das detaillierte Werbetools, die in viele Social-Media-Plattformen integriert sind lassen Sie Desinformationskampagnen ausnutzen Confirmation Bias by Maßgeschneiderte Nachrichten zu Leuten, die bereits geneigt sind, ihnen zu glauben.

Wenn ein Nutzer häufig auf Facebook-Links von einer bestimmten Nachrichtenquelle klickt, wird Facebook dies auch tun neigen dazu, dieser Person mehr vom Inhalt dieser Seite zu zeigen. Dieser sogenannte "Filterblase"Effekt kann Menschen aus verschiedenen Perspektiven isolieren und Bestätigungsvorstellungen verstärken.

Unsere eigenen Untersuchungen zeigen, dass Social-Media-Plattformen die Benutzer weniger unterschiedlichen Quellen aussetzen als nicht-soziale Medien wie Wikipedia. Da dies auf der Ebene einer ganzen Plattform und nicht eines einzelnen Benutzers liegt, nennen wir dies die Homogenität Bias.

Ein weiterer wichtiger Bestandteil von Social Media sind Informationen, die auf der Plattform angezeigt werden, je nachdem, welche Klicks am häufigsten erzielt werden. Wir nennen das Beliebtheitsbias, weil wir herausgefunden haben, dass ein Algorithmus zur Popularisierung von Inhalten die Gesamtqualität von Informationen auf der Plattform negativ beeinflussen kann. Dies führt auch zu bestehenden kognitiven Verzerrungen und verstärkt das, was unabhängig von seiner Qualität populär erscheint.

All diese algorithmischen Verzerrungen können durch manipuliert werden soziale BotsComputerprogramme, die über Social-Media-Konten mit Menschen interagieren. Die meisten Social Bots, wie Twitter Big Ben, sind harmlos. Einige verbergen jedoch ihre wahre Natur und werden für böswillige Absichten wie Desinformation fördern oder falsch Schaffung des Erscheinungsbildes einer Graswurzelbewegung, auch "Astroturfing" genannt. Wir fanden Beweise für diese Art von Manipulation im Vorfeld der 2010 US Midterm Wahl.

Um diese Manipulationsstrategien zu untersuchen, entwickelten wir ein Tool zur Erkennung von Social Bots Botometer. Botometer verwendet maschinelles Lernen, um Bot-Konten zu erkennen, indem es Tausende von verschiedenen Funktionen von Twitter-Konten untersucht, wie die Zeiten seiner Beiträge, wie oft es twittert und die Konten, denen es folgt und retweets. Es ist nicht perfekt, aber es hat gezeigt, dass so viele wie 15-Prozent der Twitter-Accounts sind Bots.

Unter Verwendung von Botometer in Verbindung mit Hoaxy analysierten wir den Kern des Fehlinformationsnetzwerks während der 2016 US Präsidentschaftskampagne. Wir fanden viele Bots, die sowohl die kognitiven, Bestätigungs- und Popularitätsvorurteile ihrer Opfer als auch die algorithmischen Vorurteile von Twitter ausnutzten.

Diese Bots sind in der Lage, Filterbläschen um verletzliche Benutzer herum aufzubauen und sie mit falschen Behauptungen und Fehlinformationen zu versorgen. Erstens können sie die Aufmerksamkeit menschlicher Benutzer auf sich ziehen, die einen bestimmten Kandidaten unterstützen, indem sie die Hashtags des Kandidaten twittern oder die Person erwähnen und retweeten. Dann können die Bots falsche Behauptungen verschärfen, indem sie Artikel aus Quellen mit niedriger Glaubwürdigkeit, die bestimmten Keywords entsprechen, retweeten. Diese Aktivität macht den Algorithmus auch für andere Benutzer interessant, die falsche Geschichten verbreiten.

Verständnis komplexer Sicherheitslücken

Wie unsere Forschung und andere zeigen, wie Individuen, Institutionen und sogar ganze Gesellschaften in sozialen Medien manipuliert werden können, gibt es viele Fragen links um zu antworten. Es ist besonders wichtig zu erfahren, wie diese unterschiedlichen Vorurteile miteinander interagieren, wodurch möglicherweise komplexere Schwachstellen entstehen.

Tools wie unseres bieten Internetnutzern mehr Informationen über Desinformation und damit einen gewissen Schutz vor dessen Schäden. Die Lösungen werden wahrscheinlich nicht nur technologischobwohl es wahrscheinlich einige technische Aspekte für sie geben wird. Aber sie müssen berücksichtigen die kognitiven und sozialen Aspekte von dem Problem.

Über den Autor

Giovanni Luca Ciampaglia, Wissenschaftlicher Assistent, Indiana University Network Science Institute, Indiana University und Filippo Menczer, Professor für Informatik und Informatik; Direktor des Zentrums für komplexe Netzwerke und Systemforschung, Indiana University

Dieser Artikel wurde ursprünglich veröffentlicht am Das Gespräch.. Lies das Original Artikel.

Bücher zum Thema

at

Danke für den Besuch InnerSelf.com, wo sind sie 20,000+ lebensverändernde Artikel, die „Neue Einstellungen und neue Möglichkeiten“ fördern. Alle Artikel sind übersetzt in Über 30 Sprachen. Abonnieren zum InnerSelf Magazine, das wöchentlich erscheint, und zu Marie T Russells Daily Inspiration. Innerself Magazin erscheint seit 1985.

Danke für den Besuch InnerSelf.com, wo sind sie 20,000+ lebensverändernde Artikel, die „Neue Einstellungen und neue Möglichkeiten“ fördern. Alle Artikel sind übersetzt in Über 30 Sprachen. Abonnieren zum InnerSelf Magazine, das wöchentlich erscheint, und zu Marie T Russells Daily Inspiration. Innerself Magazin erscheint seit 1985.