Sicher, Ihr KI-Assistent kann einen Termin für Sie buchen, aber was ist mit einem sinnvollen Gespräch? Shutterstock / Bas Nastassia

Sicher, Ihr KI-Assistent kann einen Termin für Sie buchen, aber was ist mit einem sinnvollen Gespräch? Shutterstock / Bas Nastassia

Google vor kurzem enthüllt seine neueste sprechende KI namens Duplex. Duplex klingt wie eine echte Person, komplett mit Pausen, "umms" und "ahhs".

Der Technologieriese sagt, er könne mit Leuten am Telefon sprechen, um Termine zu vereinbaren und die Öffnungszeiten zu überprüfen.

In aufgezeichneten Gesprächen, die bei der Enthüllung von Google gespielt wurden, wurde nahtlos mit den Menschen auf der Empfangsseite gesprochen, die anscheinend überhaupt nicht wussten, dass sie nicht mit einer anderen Person sprachen.

Diese Anrufe verließen die technologieorientiertes Publikum auf der Google-Show schnappt nach Luft und jubelt. In einem Beispiel verstand die KI sogar, wann die Person, mit der sie sprach, durcheinander geraten war, und konnte das Gespräch weiter verfolgen und angemessen reagieren, wenn ihr mitgeteilt wurde, dass sie keine Buchung vornehmen musste.

Der Aufstieg der KI-Assistenten

Wenn Sie einen der derzeit verfügbaren Sprachassistenten verwendet haben, z Google Home, Apples Siri oder Amazon EchoDiese Flexibilität könnte Sie überraschen. Diese Assistenten sind notorisch schwierig für andere als die Standardanforderungen zu verwenden, z. B. einen Kontakt anzurufen, einen Titel abzuspielen, eine einfache Websuche durchzuführen oder eine Erinnerung festzulegen.

Wenn wir mit diesen Assistenten der aktuellen Generation sprechen, sind wir uns immer bewusst, dass wir mit einer KI sprechen, und wir passen das, was wir sagen, oft so an, dass wir hoffen, dass unsere Chancen, dass es funktioniert, maximiert werden.

Aber die Leute, die mit Duplex sprachen, hatten keine Ahnung. Sie zögerten, zogen sich zurück, übersprangen Wörter und änderten sogar die Fakten während eines Satzes. Duplex hat keinen Beat verpasst. Es schien wirklich zu verstehen, was los war.

Mehr lesen: Intelligente Lautsprecher könnten der Wendepunkt für die Heimautomation sein

Ist die Zukunft also früher gekommen als erwartet? Ist die Welt voll von Online- (und Telefon-) KI-Assistenten, die sich glücklich unterhalten und alles für uns tun? Oder schlimmer noch, werden wir plötzlich von intelligenten KIs mit ihren eigenen Gedanken und Ideen umgeben sein, die uns Menschen einschließen können oder nicht?

Die Antwort ist ein klares Nein. Um zu verstehen, warum, ist es hilfreich, einen kurzen Blick unter die Haube zu werfen, was eine KI wie diese antreibt.

Duplex: wie es funktioniert

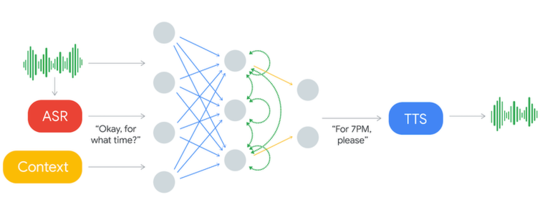

Dies ist, was die Duplex AI System sieht aus wie.

Eingehender Ton wird über ein ASR-System verarbeitet. Dies erzeugt Text, der mit Kontextdaten und anderen Eingaben analysiert wird, um einen Antworttext zu erzeugen, der über das Text-to-Speech-System (TTS) vorgelesen wird. Google

Eingehender Ton wird über ein ASR-System verarbeitet. Dies erzeugt Text, der mit Kontextdaten und anderen Eingaben analysiert wird, um einen Antworttext zu erzeugen, der über das Text-to-Speech-System (TTS) vorgelesen wird. Google

Das System nimmt die „Eingabe“ (links gezeigt) entgegen, die die Stimme der Person ist, mit der es am Telefon spricht. Die Stimme durchläuft die automatische Spracherkennung (ASR) und wird in Text (geschriebene Wörter) umgewandelt. Das ASR selbst ist ein fortschrittliches KI-System, das jedoch bereits in vorhandenen Sprachassistenten verwendet wird.

Der Text wird dann gescannt, um die Art des Satzes zu bestimmen (z. B. eine Begrüßung, eine Aussage, eine Frage oder eine Anweisung) und wichtige Informationen zu extrahieren. Die Schlüsselinformationen werden dann Teil des Kontexts. Dies ist eine zusätzliche Eingabe, die das System auf dem neuesten Stand hält, was bisher in der Konversation gesagt wurde.

Der Text aus dem ASR und dem Kontext wird dann an das Herz von Duplex gesendet, das als künstliches neuronales Netzwerk (ANN) bezeichnet wird.

In der obigen Abbildung wird die ANN durch die Kreise und die sie verbindenden Linien dargestellt. ANNs sind lose an unser Gehirn angelehnt, die Milliarden von Neuronen haben, die zu riesigen Netzwerken verbunden sind.

Noch kein Gehirn

ANNs sind jedoch viel einfacher als unser Gehirn. Das einzige, was dieser versucht, ist, die eingegebenen Wörter mit einer geeigneten Antwort abzugleichen. Das ANN lernt, indem es Transkripte von Tausenden von Gesprächen von Personen zeigt, die Buchungen für Restaurants vornehmen.

Mit genügend Beispielen lernt es, welche Arten von Eingabesätzen von der Person zu erwarten sind, mit der es spricht, und welche Arten von Antworten für jede Person zu geben sind.

Die vom ANN generierte Textantwort wird dann an einen Text-to-Speech-Synthesizer (TTS) gesendet, der sie in gesprochene Wörter umwandelt, die dann der Person am Telefon vorgespielt werden.

Wieder einmal ist dieser TTS-Synthesizer eine fortgeschrittene KI - in diesem Fall ist er weiter fortgeschritten als die auf Ihrem Telefon, da er von jeder normalen Stimme kaum zu unterscheiden ist.

Das ist alles dazu. Obwohl es auf dem neuesten Stand der Technik ist, ist das Herz des Systems eigentlich nur ein Textabgleich. Aber Sie könnten fragen - wenn es so einfach ist, warum konnten wir es nicht vorher tun?

Eine gelernte Antwort

Tatsache ist, dass die menschliche Sprache und die meisten anderen Dinge in der realen Welt zu variabel und ungeordnet sind, um von normalen Computern gut behandelt zu werden, aber diese Art von Problem ist perfekt für die KI.

Beachten Sie, dass die von der KI erzeugte Ausgabe vollständig von den Gesprächen abhängt, die während des Lernens gezeigt wurden.

Dies bedeutet, dass verschiedene AIs geschult werden müssen, um Buchungen unterschiedlicher Art vorzunehmen. So kann beispielsweise eine AI Restaurants und eine andere Haartermine buchen.

Dies ist notwendig, da die Arten von Fragen und Antworten für verschiedene Arten von Buchungen sehr unterschiedlich sein können. Auf diese Weise kann Duplex auch viel besser sein als die allgemeinen Sprachassistenten, die viele Arten von Anfragen bearbeiten müssen.

Jetzt sollte klar sein, dass wir in naher Zukunft keine gelegentlichen Gespräche mit unseren KI-Assistenten führen werden. Tatsächlich sind alle unsere aktuellen AIs nichts anderes als Mustervergleicher (in diesem Fall übereinstimmende Textmuster). Sie verstehen nicht, was sie hören, was sie sehen oder was sie sagen.

Pattern Matching ist eine Sache, die unser Gehirn tut, aber sie tun auch so viel mehr. Der Schlüssel zur Schaffung einer stärkeren KI könnte darin bestehen, mehr Geheimnisse des Gehirns zu entschlüsseln. Wollen wir Nun das ist eine andere Frage.![]()

Über den Autor

Peter Stratton, Postdoktorand, Die Universität von Queensland

Dieser Artikel wird erneut veröffentlicht Das Gespräch unter einer Creative Commons-Lizenz. Lies das Original Artikel.